Olá pessoal,

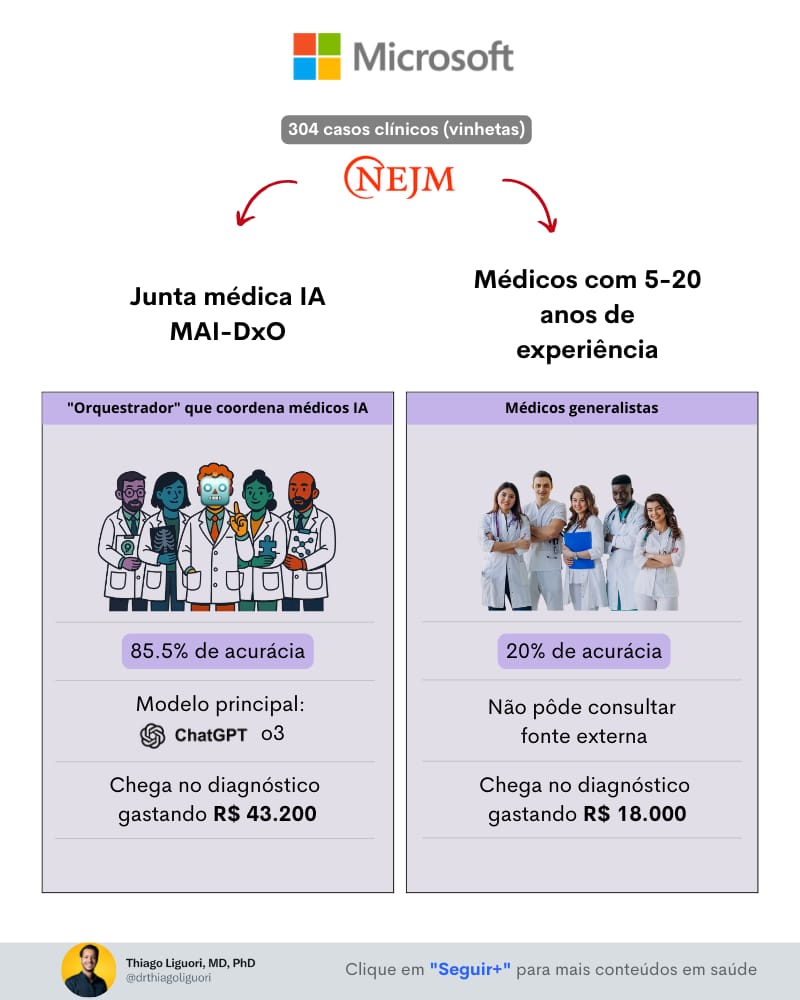

Um novo racional para diagnóstico médico com IA foi proposto pelo time da Microsoft, chamado “diagnóstico sequencial por referência”, com resultados animadores » 85.5% de acerto versus 20% de médicos generalistas.

Esse estudo (pre-print) teve bastante repercussão no meio médico, então resolvi fazer um deep dive para entender melhor os prós e contra desse novo método.

Boa leitura!

Tempo de leitura : 5 minutos

💬 Em pauta

TL:DR

O estudo é legal 👍 , mas ainda é cedo para comemorar.

Nós estamos na "fase 2” de evolução dos estudos sobre factibilidade, segurança e forma de operação dos LLMs no apoio ao diagnóstico médico.

Ou seja, ainda precisamos de mais estudos nessa fase para chegar melhor preparados para a “fase 3” que promete ser a mais desafiadora.

PS: não confundir com estudos clínicos randomizados fase 1/2/3, aqui foi só uma classificação que eu criei para facilitar o entendimento 😉 .

Em um futuro breve, para evoluirmos, precisaremos fazer com que diferentes sistemas possam processar dados clínicos (anamnese, triagem, exames laboratoriais, exames de imagem, transcrições de consultas, visitas ao pronto-socorro, relatório de cirurgia, etc) em tempo real, interagir com LLMs, fazer um check com a equipe de saúde e alinhar um output coordenado para gerar valor de fato e melhorar a jornada de cuidado dos pacientes em diferentes contextos. Sem contar com o fato de que muitas vezes estes dados estão fragmentados e/ou faltando.

Precisamos começar a olhar para isso se quisermos usar de fato os LLMs para apoio à diagnóstico.

Ok, mas o que o estudo da Microsoft mostrou?

Que uma “junta médica IA” com diferentes agentes focados cada um em uma parte específica do diagnóstico ou racional clínico, conseguiu alcançar uma alta acurácia (85.5%) quando comparados a médicos generalistas (20%), ao avaliar 304 casos clínicos complexos do MGH (Massachusetts General Hospital), que foram consolidados pelo NEJM.

O sistema foi chamado de MAI Diagnostic Orchestrator (MAIDxO).

No estudo, tanto médico quanto IA recebem um resumo inicial do caso e podem fazer perguntas adicionais, recebendo respostas a medida que a avaliação evolui.

Exemplo:

Paciente com tosse e secreção amarelada há 2 semanas.

Médico ou IA: Teve febre?

Avaliador: Sim, de 39,1˚C por 2 dias.

Médico: Como está o hemograma e PCR?

Avaliador: Hemograma apresenta leucocitose com desvio à esquerda de PCR de 9.2.

Para começo de conversa, algumas limitações aqui:

Primeiro caso: Rabdomiosarcoma embrionário em uma mulher de 29 anos

A incidência disso é <1 em 1 milhãoOs médicos não puderam consultar qualquer ferramenta, só a memória, sendo que para casos raros como esse muitas vezes nós revisamos a literatura, pedimos opinião de especialistas e afins

Todos os médicos eram generalistas

Na minha visão, os LLMs tinham uma vantagem nessa história.

Eu vejo mais benefício em colocarmos mais casos do dia-a-dia, que reforçam nuances biopsicossociais, visão do paciente e dificuldade de acesso / recursos.

A primeira vista, não podemos extrapolar o que vemos nos resultados com vinhetas clínicas do NEJM versus o que temos na realidade com casos clínicos complexos, com informações fragmentadas em um paciente em que precisamos olhar para sua saúde integral.

Esse paciente tem escolhas, preferências e desejos diferentes, o que agrega uma camada de complexidade maior do que simplesmente uma visão mais bidimensional do diagnóstico.

Achei um pesquisador que reflete bem essa visão mais cética sobre os estudos 1:1 com IA e médicos.

É o Jerome Kassier (ex-editor no NEJM), que propõe uma lista de requisitos 👇

Quais tipos de casos clínicos foram usados no desenvolvimento da IA?

↳ Será que não vale ter mais casos do dia-a-dia e não só os mais complexos como as vinhetas no NEJM?Os casos eram reais ou inventados?

Os casos eram suficientemente complexos para desafiar um bom médico?

↳ acho que muito complexo pode ser ruim também.Os diagnósticos foram claros e baseados em critérios científicos?

Os casos incluíam pistas falsas, histórico variável e resultados laboratoriais confusos, como na prática clínica?

Foram testados casos suficientes?

↳ Neste caso sim, com 304 casos.Quem avaliou a precisão diagnóstica e a consistência do plano de tratamento recomendado?

Esses avaliadores humanos tiveram acesso aos mesmos dados clínicos que o programa de IA?

O número de casos de teste foi adequado?

Os avaliadores humanos sabiam se o julgamento foi feito pela IA ou pelo médico?

↳ super importante os testes cegos nesta fase que estamos!Como foram resolvidas as diferenças entre diagnósticos e recomendações da IA e dos humanos?

A IA consegue explicar a base de suas conclusões de forma semelhante a um humano quando há discrepâncias significativas?

↳ ainda não porque opera como black box

Vejo algumas restrições.

A seleção de casos foi específica e não representativa da massa de atendimentos da atenção primária (expertise dos médicos convidados a participar).

As vinhetas do NEJM são casos cuidadosamente selecionados para fins educacionais, com foco em condições raras, complexas ou com apresentações atípicas, destinadas a desafiar o raciocínio diagnóstico de médicos experientes (muitas vezes especialistas).

Esses casos não representam a diversidade e a prevalência das condições clínicas comuns em ambientes de atenção primária ou hospitalar. A realidade clínica envolve uma alta prevalência de condições como hipertensão, diabetes e infecções respiratórias, que raramente são o foco das vinhetas.

Além disso, as vinhetas são estruturadas para enfatizar a confirmação diagnóstica por autópsia ou achados anatomopatológicos, um recurso pouco comum na prática clínica diária, em que decisões são frequentemente baseadas em dados clínicos e exames acessíveis. Essa abordagem centrada em casos excepcionais pode superestimar a capacidade da IA em lidar com a variabilidade e incerteza dos cenários clínicos reais, já que fatores como comorbidades, sintomas inespecíficos e limitações de recursos são predominantes.

Associado a isso, a escolha destes casos específicos pode introduzir um viés de seleção, pois esses casos são projetados para serem resolvidos com informações específicas e bem delineadas, favorecendo sistemas de IA que processam dados estruturados.

Na prática clínica, médicos frequentemente encontram informações incompletas ou ambíguas, como relatos vagos de pacientes ou resultados de exames inconclusivos.

Cadê o uptodate, aquele Google para aprofundar nas hipóteses enquanto o paciente realiza a biópsia?

A consulta médica online em bases de dados, artigos, revisões e diretrizes é fundamental para a prática clínica.

Em resumo…

Eu estou animado, mas um pouco cético sobre o potencial da IA no curto prazo como ferramenta diagnóstica. Bastante mato alto ainda.

Vejo mais aplicação no curto prazo para workflow clínico, papelada e burocracias.

O que você acha?

Por hoje é só!

Mandem feedbacks, é só responder esse e-mail.

Se você achou o conteúdo interessante, compartilhe.

Domingo que vem tem mais,

Abraço!

Thiago Liguori

Gif by Grittv on Giphy